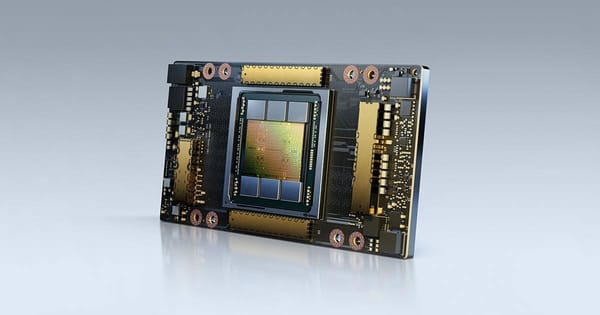

花了高端 GPU 的钱,利用率却不到 30%:算力租赁的那些坑

很多团队在算力租赁上花了高端 GPU 的钱,却只跑出不到 30% 的利用率。问题往往不在模型,而在选型、计费方式和调度策略。本文结合真实案例,梳理了算力租赁中最常见的三个坑,并给出碎片化计费、动态扩容和任务优先级管理等实用优化方法,帮助团队显著提升 GPU 利用率并降低成本。

很多团队在算力这件事上,第一步就走歪了。

花的是 A100、H100 这种高端 GPU 的钱,结果一算账,平均利用率不到 30%。

这基本等于什么?

相当于买了一辆跑车,只在市区里当代步车开。

很贵,也很亏。

问题在于,很多人租完 GPU 之后,就不再管了。

默认的逻辑是:硬件够强,效率自然就高。

但现实恰恰相反。

算力利用率低,往往不是模型不行,而是被一些非常基础、却极其常见的坑拖垮了。

第一个坑:盲目选整卡包月

这是最典型、也是最容易忽略的问题。

很多团队一上来就选“整卡包月”,看起来省事,实际上非常浪费。

场景往往是这样的:

- 白天有人跑任务

- 晚上几乎没人动 GPU

- 但 GPU 24 小时都在“站岗”

结果就是,每天有一半以上的时间算力是空转的。

钱已经付了,但卡在发呆。

如果你的工作负载明显集中在白天,这种模式几乎一定会亏。

第二个坑:配置严重过载

简单说一句话:大马拉小车。

有些任务,本身数据量不大、batch 很小,却直接用 A100 去跑。

看起来很“豪华”,实际上是纯浪费。

高端 GPU 的优势在于吞吐,而不是“单任务显得快”。

当任务规模撑不起卡的能力时,多出来的算力就是白白烧钱。

这是算力成本被“吃掉”的第二大来源。

第三个坑:调度毫无章法

这是很多团队最容易忽视,但影响非常大的问题。

常见情况是:

- 多个任务扎堆在同一时间提交

- 有的 GPU 忙到显存爆、任务排队

- 有的 GPU 却整天闲着,几乎没事干

没有统一调度,也没有优先级管理。

结果不是算力不够,而是算力用得一塌糊涂。

三个立刻见效的优化思路

如果前面这三个坑,你至少踩中过一两个,那下面这几条,基本都能用得上。

而且不是“理论优化”,而是立刻能看到效果的那种。

1. 换成碎片化计费

不要一上来就包月。

改成 按时计费、按使用时长结算 的模式,效果通常非常明显。

- 白天跑任务,按实际使用时间付费

- 晚上不用 GPU,就不花钱

在负载不连续的团队里,这一步往往就能 直接把算力成本砍掉 30%~50%。

2. 动态扩容,而不是“一刀切”

不同任务,用不同等级的 GPU。

- 小任务,用入门级卡

- 大任务,自动切换到高端卡

让算力配置跟任务规模匹配,而不是“统一拉满”。

这样做的好处只有一个:

每一块钱,都花在真正需要的地方。

3. 给任务设优先级,错峰运行

这是调度层面最容易被忽略的一点。

可以简单分三类:

- 核心任务:高优先级,优先抢占算力

- 普通任务:正常排队

- 非紧急任务:错峰运行,专门吃“闲置时间”

只要把这一步做好,GPU “有的忙死、有的闲死”这种情况,基本就能消失。

高效利用算力,就选晨涧云AI算力租赁,支持按时计费,原系统环境上更换显卡、升降配置,优化算力调度,长租更优惠。

一个真实的优化结果

之前帮一个 AI 团队做过算力调度优化。

调整前:

- GPU 平均利用率:38%

调整后:

- GPU 平均利用率:81%

- 每月算力成本:直接下降约 40%

模型没换,算法没改,GPU 型号也没变。

只是把用法换对了。

这就是算力方案选对与选错之间的差距。

写在最后

算力这件事,真的不是“卡越贵越好”。

更多时候,问题不在算力不够,而在算力被浪费得太彻底。

你可以不追求极致优化,

但至少别让 GPU 在你看不见的地方,白白烧钱。

最后问一句:

你的 GPU 利用率,现在能到多少?