AI 大模型浪潮下,算力租赁为什么突然成了“香饽饽”

随着 AI 大模型快速发展,算力需求持续攀升,GPU 成为核心稀缺资源。在出口限制与供应不确定性加剧的背景下,算力租赁行业迎来爆发式增长。谁能稳定获取 GPU 资源,谁就掌握竞争主动权。本文从产业链、资本动向与政策工具等角度,梳理了当前算力租赁赛道的现实逻辑与发展趋势。

AI 大模型已经不是什么新鲜词了。 从 ChatGPT 开始,到各类国产大模型密集发布,几乎所有人都在谈 AI。

但真正支撑这一切的,并不是模型名字有多响,而是两个字:算力。

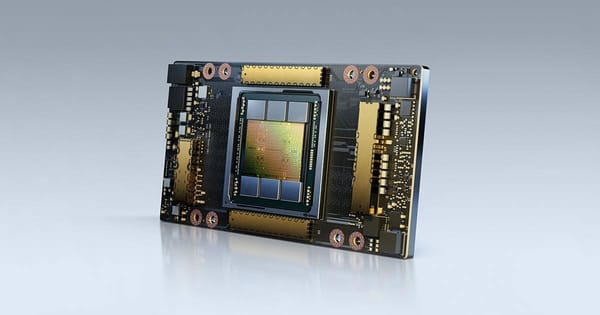

算力不是抽象概念。它是服务器,是 GPU,是电力、网络和机房,也是一个完整而复杂的产业链。更现实的是,算力还牵扯到供应链安全问题。这个问题,在最近一两年变得格外敏感。

被反复提起的“卡脖子”,正在改变行业走向

近一段时间,围绕先进制程和 AI 芯片的限制不断加码。 英伟达推出面向国内市场的 A800、H800 等产品,而高端显卡出口屡屡受限,预期变得极不稳定。

对算力运营方来说,这不是抽象风险,而是实打实的压力。

一旦未来供给不确定,最直接的反应只有一个:抢卡。

抢货潮出现后,GPU 成本随之上涨。这种上涨并不会被运营方完全消化,而是会逐级传导到下游,最终体现在算力租赁价格上。

结果反而很清楚: 算力租赁行业,成了这一轮变化中的直接受益者。

谁能拿到卡,谁就有话语权

在 GPU 成为稀缺资源的背景下,算力租赁的竞争逻辑发生了变化。

以前比的是谁的机房多、价格低、服务快; 现在比的,是谁能持续拿到卡,谁能形成规模化算力储备。

谁先拿到计算卡,谁在资本市场上的稀缺性就越高。

这也是为什么,算力租赁被越来越多投资者视为一条确定性较强的赛道。

晨涧云GPU算力租赁平台提供丰富的GPU算力租用资源,包括极具性价比的A100、4090、3090等显卡,支持Windows云主机和Linux云容器,更有性能强劲的裸金属物理机可供租赁。

GPU,已经取代 CPU 成为真正的“发动机”

从技术演进来看,一个明显的趋势是: 算力重心,正在从 CPU 转向 GPU。

无论是大模型训练,还是推理阶段的规模化部署,GPU 都已经成为不可替代的核心资源。可以说,GPU 是当前 AI 技术落地的真正引擎。

上游算力资源的稀缺性,也正是在这一背景下被迅速放大。

有机构预测,未来单个头部大模型厂商,在推理阶段对 A100 级别 GPU 的需求,可能达到 10 万张量级。这个数字,放在任何一个市场里,都不算小。

资本与企业,正在加速入场

在算力租赁赛道上,已经能看到越来越多具体案例。

例如,一些新晋玩家开始把算力租赁,视为公司的第二增长曲线。 部分企业通过自采 GPU 服务器,已经具备形成 2000P 以上算力集群的理论能力,同时配套的 AI 超算中心机房也逐步到位。

再比如,有上市公司提前大额预付资金采购高端服务器,为客户提供云计算、云存储服务,整体收入规模仍在爬坡阶段,但算力云服务业务已经局部出现饱和。

“拿卡能力”,成了核心竞争力

在当前阶段,算力租赁厂商的核心竞争力,正在被重新定义。

不只是运维能力、服务能力,更重要的是: 你能不能稳定地拿到算力芯片资源。

有些企业的优势,并不在机房规模,而在于其合作伙伴在 AI 制造和算力基础设施方面的经验积累。 通过与英伟达、新华三等厂商保持深度合作,已经跑通了从算力部署到租赁交付的完整链条。

这类厂商,在当前环境下具备明显优势。

算力券出现,市场开始“软性调节”

为了推动算力产业发展,一些地方开始尝试发放“算力券”。

从形式上看,这是对算力需求方的补贴; 从更高层视角看,这其实是一种变相的招商引资。

一方面,它降低了中小企业获取算力资源的门槛; 另一方面,也给算力供需双方提供了更灵活的定价空间。

这种机制,在一定程度上有助于刺激市场持续活跃,而不是被高昂的算力成本过早“劝退”。

真正的竞争,才刚刚开始

需要明确的是,算力租赁并不是一门轻松的生意。

即便是头部云厂商,也不仅要建设大规模算力集群,还必须具备成熟的运维和调度能力,帮助客户真正把算力“用满、用好”。

在这两点上,国内玩家仍有不少功课要补。

而回到“高端 GPU 被限制”这个问题本身,英伟达真正的壁垒,也并不只在制程或硬件上,更体现在 CUDA 软件生态 多年的积累。

因此,构建自主可控的软硬件生态,已经成为想在算力租赁市场长期立足的关键方向。

结语:算力租赁,是资源博弈的生意

最近两年,算力行业仍处在早期阶段。 玩家不断涌入,生态链迅速拉长,每个人都希望分一杯羹。

但在这个“卡难求”的时代,规则其实并不复杂:

谁能掌握上游芯片资源,谁就更有可能在算力租赁这条赛道上走得更远。

竞争,才刚刚开始。