AI算力

算力:数字世界的“氪石”和未来战争的底牌

本文梳理了算力从芯片、本地计算到云计算的发展过程,解释了 AI 时代算力需求为何远超摩尔定律,引发全球“算力战争”。对比了中美在算力布局上的不同路径,并解析欧洲、日本的差异化策略,重点讨论太空算力在能源、散热和效率上的潜在优势。强调算力既是国家战略资源。

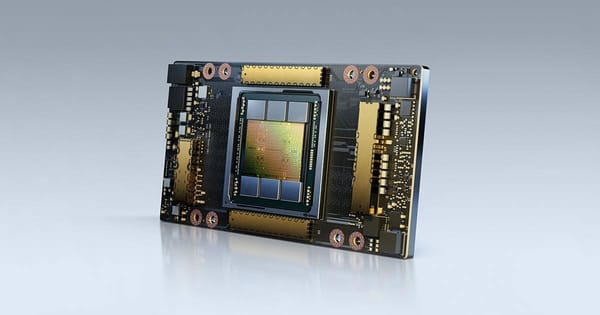

GPU显卡资源,英伟达(NVIDIA)最新的H100、H200、B200以及普遍使用的RTX 4090、RTX 3090、A100等;算力基础设施、算力租赁与云服务,AI专用实例、算力集群服务、定价策略等;算力性能基准测试,性能排行榜,及一些在特定场景下最适合的GPU选型等。

AI算力

本文梳理了算力从芯片、本地计算到云计算的发展过程,解释了 AI 时代算力需求为何远超摩尔定律,引发全球“算力战争”。对比了中美在算力布局上的不同路径,并解析欧洲、日本的差异化策略,重点讨论太空算力在能源、散热和效率上的潜在优势。强调算力既是国家战略资源。

AI算力

A100显卡价格暴跌超50%,40GB版2.8-4元/小时,80GB版4-6.5元/小时,包月9800-30000元。相比H100便宜70%,显存40-80GB适合大模型微调和推理。国产昇腾910B月租2万元形成竞争。供给充足、推理需求上升、价格战常态化。短期项目按需计费,长期包月省20-50%。

AI算力

AI算力租赁是云端共享显卡服务,按需计费无需购买硬件。2026年中国市场规模达2600亿元,年增速20%以上。分为云巨头(阿里云、腾讯云)、专业平台(AutoDL、晨涧云)和差异化平台三类。推理需求占比上涨,国产芯片加速替代。从"买卡"到"租服务",从裸算力到MaaS,AI算力成为新型基础设施。

AI算力

根据VideoCardz对10个国家和地区的14款当代显卡最低现货价格统计,过去三个月间全球显卡价格平均上涨15%。RTX 5090全球均涨32%,RTX 5070 Ti紧随其后,均涨25%。中国国内,涨幅最高的反而是RTX 5060 Ti 16G,达23.08%。AMD和Intel整体表现较为克制。

AI算力

2025年GPU算力租赁市场突破千亿规模,但价格大幅回落超70%。市场从"抢卡"转向"拼交付",推理需求快速崛起预计2028年占比达73%。企业竞争焦点转向异构调度、绿色能效和生态服务能力。东数西算与算力券政策强力引导,液冷技术使PUE降至1.1,行业迈向高质量发展阶段。

AI算力

本文围绕近期出现的 32GB 魔改版 RTX 5080 显卡展开,梳理了其来源、改装方式及面向的本地 AI 运算市场。解释了为何在大模型推理场景下,显存容量往往比纯算力更关键,以及 32GB 版 5080 如何以低于 5090 的成本填补高显存需求空档。

AI算力

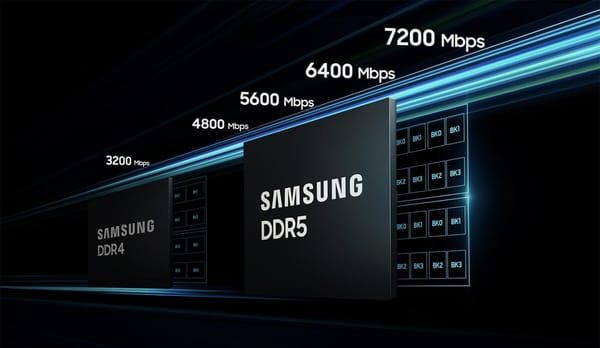

自 2025 下半年以来,DDR5 和服务器 DRAM 价格出现 400%–500% 的历史级暴涨,AI 服务器与 HBM 抢占了绝大部分先进产能。本文从 AI 军备赛、HBM 产能挤压、DRAM 定价逻辑变化和厂商策略等角度进行拆解,以及国产存储与新型存储技术的潜在机会。

AI算力

本文从 CES 2026 发布内容出发,系统梳理了英伟达从 Vera Rubin 架构,到 BlueField-4 DPU 推理架构、Physical AI、自动驾驶与人形机器人的完整布局。如何把 72 张 GPU 虚拟成一颗「超级芯片」,以及通过拆分「算力」与「记忆」重构推理成本结构。

AI算力

本文梳理了 NVIDIA 新一代 Rubin 架构及 RTX 6090 的可能规格与定位。Rubin 将在 3nm 工艺、AI 算力密度和神经渲染上大幅强化,并下放到 RTX 60 系列消费级显卡。传闻中 RTX 6090 采用 GR202 核心、512-bit 32GB GDDR7、功耗高达 700–800W。

AI算力

从英伟达 H100 和 DGX-H100 超算入手,解析算力在 AI 时代为何被视为“新型能源”,并以 DeepSeek R1 为例,展示算法优化如何在有限算力下撬动成本与性能,对“算力即胜负”的观点提出反思。最后指出:算力重要,但真正决定 AI 竞争格局的是算力、算法、数据、产业链与人才的综合实力。

AI算力

本文从数据中心用电、变压器交付、电网瓶颈等角度出发,讨论了算力竞争逐渐演变为电力与基础设施竞争的趋势。分析了科技巨头为何开始自建和锁定电源,以及中国在特高压输电、能效优化和算力流入实体经济方面的系统优势,指出“电力—算力—生产力”的完整链路将决定未来 AI 竞争格局。

AI算力

本文围绕“算力云平台如何租用 GPU”展开,重点介绍了主流租用显卡的参数差异及适用场景,对比了主流算力平台的典型价格区间,解释了云主机与云容器的核心差异,并给出长租场景下需要关注的长租折扣、数据保留周期、保留系统换卡等关键因素,以便在租用 GPU 前做出更理性的选择。