晨涧云文档

首页

目录

- GPU算力租用流程

- Ubuntu查看显卡GPU利用率

- Ubuntu系统安装CUDA Toolkit + Cudnn

- Ubuntu NVIDIA显卡驱动安装

- Ubuntu用户界面入门

- Windows jupter notebook 的使用

- Windows 安装SSH Server

- windows查看显卡GPU利用率

- Ubuntu镜像

- Windows镜像

- CentOS镜像

- 深度学习 - Ubuntu

- 深度学习 - Windows

- 云计算 - Ubuntu

- 云计算 - Windows

- ComfyUI - Ubuntu

- LLaMA Factory - Ubuntu

- Stable Diffusion - Ubuntu

- Ubuntu 命令行使用

- ComfyUI - Windows

- LLaMA Factory - Windows

- Stable Diffusion - Windows

- 秋叶Stable Diffusion - Windows

- Ollama - Windows

- Ollama DeepSeek - Ubuntu

- 【模型】Ollama + Open WebUI - Ubuntu

- 【语音】 Whisper 语音转文本 - Ubuntu

- Chatbox - Windows

- Ubuntu系统安装远程连接工具

- Windows登录方式

- 常用操作

- 学术资源加速

- 文件传输

- 晨涧云概览

- 晨涧云简介

- 名词术语

- 安装显卡驱动

- 连接失败处理

- 促销活动

- Miniconda3 容器镜像

- PyTorch 容器镜像

- TensorFlow 容器镜像

- GROMACS 容器镜像

- ComfyUI 容器镜像

- Matlab - Windows

- YOLO 容器镜像

- LLaMA-Factory 容器镜像

- Wan-ComfyUI 容器镜像

- Stable-Diffusion 容器镜像

- vLLM 容器镜像

- LAMMPS 容器镜像

- Ollama 容器镜像

- Flux-ComfyUI 容器镜像

- ComfyUI应用

- Wan2.2文生视频显卡性能测试

- 深度学习场景

- 基于ResNet-50模型的显卡性能测试

- 大语言模型场景

- 使用vLLM测试大模型推理场景的显卡性能

- Qwen-ComfyUI 容器镜像

- vLLM大模型多卡推理场景显卡测试

- 科研仿真计算场景

- GROMACS分子动力学模拟计算显卡性能测试

- 【年终满减优惠活动】全系显卡算力特惠风暴!(A100除外)

- YOLO 模型训练显卡性能测试

- FluxGym-LoRA训练器 容器镜像

- Kohya_ss-LoRA训练器 容器镜像

- RustDesk远程连接

- 常见问题(FAQ)

- RustDesk远程手机端设置

- 晨涧云平台手册

- Windows操作

- GPU算力操作流程

- 云容器租用流程

- 系统预装环境

- Ubuntu操作

- 云容器控制台使用

- 云主机控制台使用

- JupyterLab使用

- 云主机镜像中心

- 云容器百度网盘使用

- 云容器

- 云容器按小时计费

- 技术相关

- 云容器镜像

- 应用场景

- WebUI使用

- 服务端口配置

- 晨涧云新老用户专享福利

- SSH隧道映射端口

- 微信登录立享6元优惠券

- VSCode连接到云主机

- conda 安装虚拟环境

- 选择Conda虚拟环境

- 安装tensorflow

- huggingface下载模型

- 晨涧云产品重磅升级:云容器按量计费+控制台实例管理全新改版,重塑AI开发效率与成本体验

- 新容器镜像来了!宝藏镜像库+秒级部署,GPU直接8折!

- 【双十一显卡狂欢】🔥NVIDIA 3090/3080 史低八折!性能猛兽,价格温柔!

- 开学季|3090显卡专属福利🎯(2025年9月)

Ollama 容器镜像

镜像包括:Ollama及OpenWebUI

云容器控制台使用:控制台使用

云容器JupyterLab使用:JupyterLab使用

选择镜像

创建实例时,选择【Ollama】镜像:

当前支持的版本

| Ollama版本 | Ubuntu版本 | CUDA版本 | Python版本 |

|---|---|---|---|

| 0.12.3 | 22.04 | 12.4 | 3.10 |

当前支持的版本会随着Ollama版本的更新而更新。

使用

访问OpenWebUI

系统创建好后可通过OpenWebUI访问进行操作

step1. 查看IP

step2. 查看端口

step3. 访问地址,默认监听到内网8001端口,可通过控制台查看8001对应的外网端口访问

http://外网IP:381xx

设置电子邮箱,以及密码。

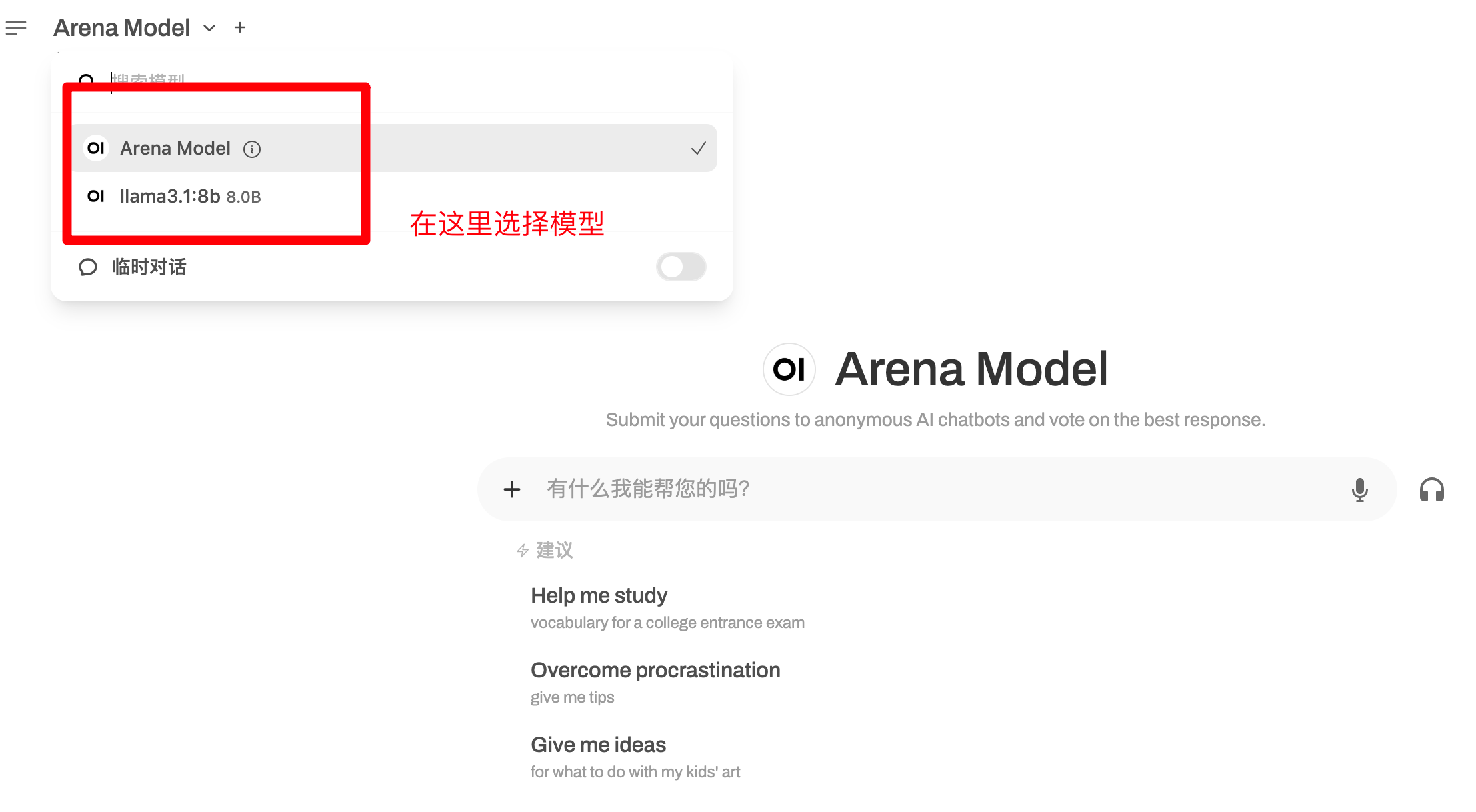

登陆后可以选择对话模型如下图,需要更多模型可以下载使用

访问OpenWebui API

创建API KEY

在Open WebUI设置中创建API KEY

下载模型

查看官方模型列表

SSH登录服务器通过命令行Pull模型

ollama pull xxxOpenWebUI中可选择以pull的模型

查看模型

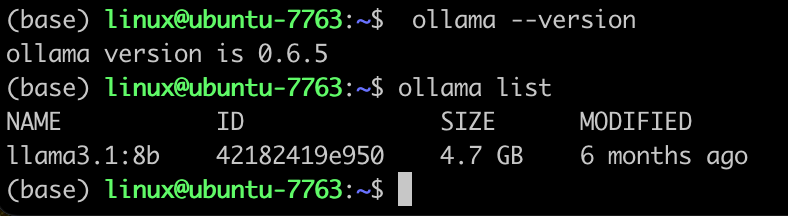

WebUi可以通过页面左上角查看,命令行通过执行 ollama list 查看

运行模型

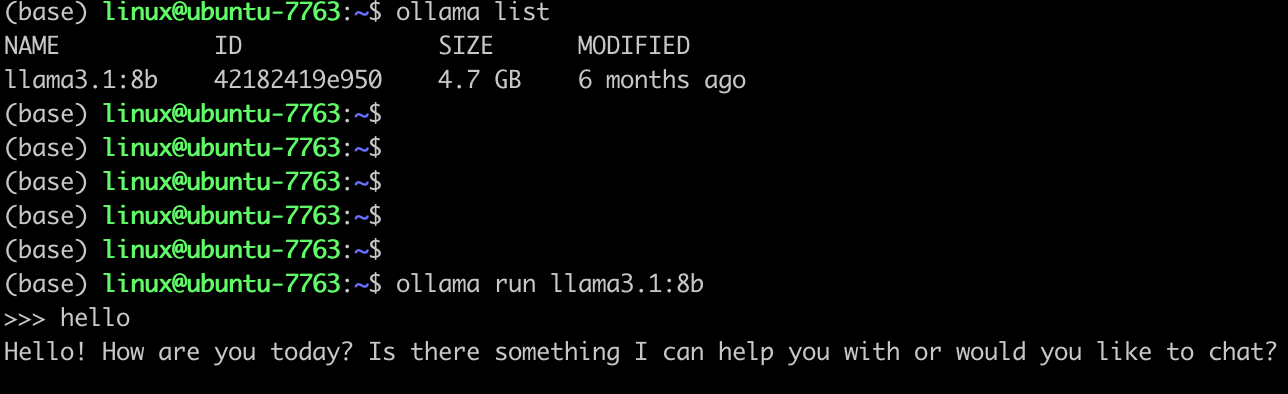

命令行输入一下命令运行模型,我们通过上一步查看有模型 llama3.1:8b,就可以通过 ollama run llama3.1:8b 去运行模型

ollama run xxx运行需要等待加载完成,就可以进行对话了

配置环境变量

Ollama 的环境变量可以在文件 /.mornai/tools/pkg/ollama/ollama_env.sh 配置:

#!/bin/bash

export OLLAMA_HOST="0.0.0.0:8002"

export OLLAMA_SCHED_SPREAD="1"

export OLLAMA_KEEP_ALIVE="1h"

export OLLAMA_MODELS="/data/ollama/models"修改或者新增环境变量后重新启动Ollama服务使环境变量生效。

启停服务

如果修改或者新增了环境变量,或者因为一些其他原因需要启停Ollama服务,可以进行如下操作:

使用 mornctl.sh 脚本

mornctl.sh ollama {start|stop|restart|status|enable|disable}start: 启动服务

stop: 停止服务

restart: 重启服务

status: 查看服务状态

enable: 服务开机自启动

disable: 取消服务开机启动